Dans un premier article sur Fabric, j’ai présenté les différentes composantes de cette solution de Microsoft . La première de ces composantes est Data Factory et elle est utilisée pour l’intégration de données.

Effectivement, il est possible d’intégrer les données avec Data Factory qui est la combinaison de deux outils déjà existants :

- Les flux de données Power Query: utilisé pour la partie connexion aux données et transformations

- Azure Data Factory : utilisé pour la partie Mouvement de données (avec les pipelines) et de suivis des activités (monitoring)

Avec l’utilisation de Data Factory nous sommes donc en mesure de nous connecter à différentes sources de données (structurées ou non), de les transformer au passage et de les sauvegarder dans un environnement accessible pour les créateurs de rapports. L’intégration des données pourra également suivre un certain flux d’activités qui aura été programmé préalablement à l’aide d’un pipeline.

Comment accéder à Data Factory ?

Pour accéder à Data Factory, à partir de Power BI Service, il faut cliquer sur le bouton situé en bas à gauche, et sélectionner Data Factory.

Une fois dans l’outil, vous verrez que 3 options s’offrent à vous :

- Créer un Flux de données Gen2

- Créer un Pipeline de données

- Vous former sur l’outil

Voyons de façon sommaire chacune des options de Data Factory

Option 1 : Flux de données Gen2

C’est la partie Power Query de l’outil. C’est dans cette partie que l’on peut se connecter aux données, les nettoyer et les transformer.

Il sera possible, à ce stade-ci, de charger les données vers un pont de destination comme dans un Lakehouse. Cette possibilité diffère du flux de données (Power Query) que l’on connait dans Power BI ou Excel où l’on va plutôt parler de Flux de données Gen1. Vous pourrez ensuite intégrer ces flux de données Gen2 dans un pipeline pour en coordonner l’exécution.

Étapes pour créer un flux de données Gen2

1 – Cliquer sur le bouton « Flux de données Gen2 »

2 – Choisissez ensuite un connecteur pour aller chercher vos données.

Si vous connaissez déjà Power Query, vous vous reconnaissez immédiatement !

Vous pouvez importer vos données en passant par le menu Obtenir les données ou bien par les raccourcis présentés au centre de la fenêtre.

3 – Une fois les transformations complétées, vous pouvez ajouter une destination avec le bouton « Ajouter une destination de données ».

Il y a 4 options qui s’offrent à vous :

- Base de données SQL Azure

- Lakehouse

- Azure Data Explorer (Kusto)

- Entrepôt

Dans mon cas, j’ai choisi le Lakehouse.

Puis j’ai sélectionné mon Lakehouse CFOMasque.

Il faut ensuite choisir la méthode de la mise à jour du flux. On peut choisir d’ajouter les données à la table ou bien de remplacer les données existantes. Dans mon cas j’ai choisi la 2e option car je veux remplacer la table chaque fois que le flux sera exécuté.

4 – Finalement, on publie le flux à l’aide du bouton approprié

La table créée avec le flux de données Power Query Gen2 est maintenant disponible dans le Lakehouse CFOmasque.

Option 2 : Le Pipeline de données

Le Pipeline de données nous permet de configurer une séquence d’activités dans un ordre particulier pour ainsi créer un mouvement de données.

On peut exécuter un flux de données, et une fois que ce flux est terminé, on exécute un second flux de données. Ceci peut être utile, entre autres, lorsque le résultat du 1er flux de données est utilisé dans un 2e flux. Il est primordial que le 1er flux soit complété avant l’exécution du second flux.

Il est possible alors de suivre le déroulement du pipeline (monitoring) et ainsi s’assurer que le mouvement de nos données s’est bien exécuté.

Vous devez analyser de grandes quantités de données et les présenter dans des rapports et tableaux de bord, avec des indicateurs de performance pertinents ? Développez vos compétences avec nos formations en Power BI.

Vous devez analyser de grandes quantités de données et les présenter dans des rapports et tableaux de bord, avec des indicateurs de performance pertinents ? Développez vos compétences avec nos formations en Power BI. |

|---|

Étapes pour créer un Pipeline de données

1 – Cliquez sur le bouton Pipeline de données.

2 – Ajoutez les activités

Nous pouvons ensuite cliquer sur Ajouter une activité de pipeline, puis sur Flux de données. Notez qu’il y a plusieurs autres options d’activités, mais que nous allons nous contenter de couvrir les flux de données dans cet article.

L’activité Flux de données apparaît dans notre pipeline, il faut alors aller sélectionner le flux de données à exécuter dans l’onglet Paramètres. Ici, nous allons chercher le flux de données créé précédemment qui se nomme Dataflow 1.

On peut ensuite ajouter une nouvelle activité. Nous allons ajouter l’exécution d’un autre flux de données en cliquant sur la flèche verte du premier Flux de données.

3 – Mettez en marche le pipeline

Une fois la 2e activité créée, nous pouvons exécuter notre pipeline en cliquant sur le bouton de mise en marche : RUN.

Si ce n’est pas déjà fait, il faudra enregistrer notre pipeline pour l’exécuter.

4 – Suivez le déroulement du pipeline (monitoring)

Il est possible de suivre l’évolution de l’exécution dans l’onglet Sortie au bas de l’écran.

Dans ce cas-ci, notez que le 1er Flux de données (Dataflow1) a été exécuté avec succès et que le 2e Flux (Dataflow2) est en cours d’exécution.

5 – Planifiez la fréquence d’exécution du pipeline

Il est possible finalement de planifier une fréquence d’exécution en cliquant sur le bouton Schedule puis en insérant la fréquence et l’heure souhaitée dans la section Planification.

Il est possible également de suivre l’exécution des pipelines dans le hub de supervision

Option 3 : Formation sur l’outil (documentation)

Remarquez que vous avez à votre disposition des articles et capsules vidéo vous permettant d’en apprendre davantage sur Data Factory et ses composantes. Je vous invite à les consulter pour vous familiariser avec les différents concepts. C’est un bon point de départ si vous débutez avec la solution !

En conclusion

Sommairement, j’ai trouvé que c’était relativement intuitif comme outils Low Code No Code. Il a été plutôt aisé de configurer les deux flux de données pour ensuite en planifier l’exécution par le pipeline.

L’avez-vous essayé? Quelles sont vos premières impressions ?

Avez-vous consulté tous les articles de cette série sur Microsoft Fabric?

Afin de recevoir nos nouveaux articles directement dans votre boite courriel, abonnez-vous à nos infolettres.

- Introduction à Microsoft Fabric, outil intégré pour l’analyse de données

- 3 étapes pour accéder à une version d’essai de Microsoft Fabric

- Accéder à OneLake directement par l’explorateur de dossiers Windows

- Microsoft Fabric : Intégrez vos données avec Data Factory

- Microsoft Fabric : Gérez vos données avec Synapse Data Engineering

Formation complémentaire

Vous devez manipuler et analyser beaucoup de données et êtes à la recherche d’un outil BI (Business Intelligence) performant, en mode libre-service ? Suivez la formation Power BI – Niveau 1.

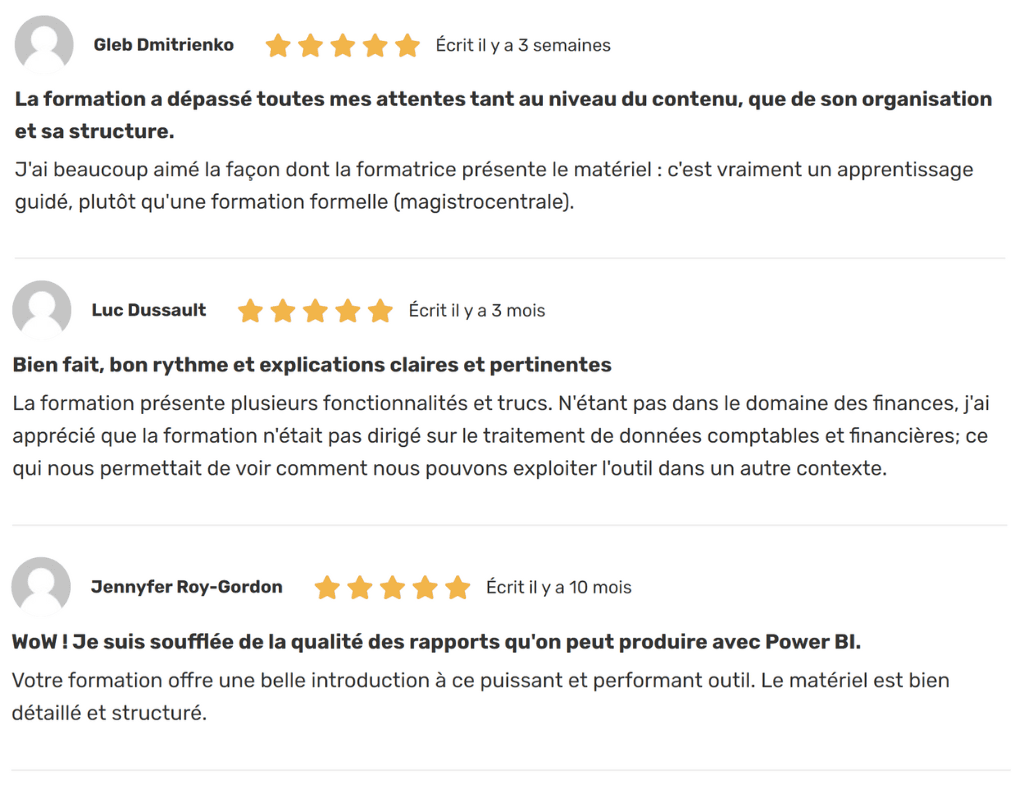

Voici quelques commentaires d’apprenants ayant suivi cette formation :

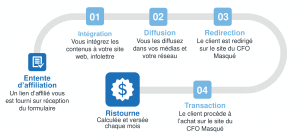

La mission du CFO masqué est de développer les compétences techniques des analystes et des contrôleurs de gestion en informatique décisionnelle avec Excel et Power BI et favoriser l’atteinte de leur plein potentiel, en stimulant leur autonomie, leur curiosité, leur raisonnement logique, leur esprit critique et leur créativité.

La mission du CFO masqué est de développer les compétences techniques des analystes et des contrôleurs de gestion en informatique décisionnelle avec Excel et Power BI et favoriser l’atteinte de leur plein potentiel, en stimulant leur autonomie, leur curiosité, leur raisonnement logique, leur esprit critique et leur créativité.